18 Juil Des data centers implantés dans des lieux insolites !

Nous abordons régulièrement le sujet des data centers autour des thématiques actuelles et du futur. Mais saviez-vous que le passé joue aussi un rôle pour ces serveurs ? En offrant un environnement insolite ! Mais quel est l’intérêt de ces lieux ? Ils répondent à une partie des critères essentiels au bon fonctionnement des data centers :

- emplacement avantageux

- consommation d’énergie raisonnée

- niveau de sécurité élevé.

En voici quelques exemples.

Une citadelle à Arras

Construite au 17ème siècle, la citadelle est une ancienne poudrière. Elle a été démilitarisée en 2010 après avoir été achetée par Decima. Cette PME a investi trois millions d’euros pour reconvertir ces 72 hectares. Elle y héberge ses serveurs sur deux niveaux de 130m² chacun.

Il s’agit d’un site classé au patrimoine de l’Unesco. De ce fait, il fallait respecter un certain nombre de contraintes :

- Ne pas toucher aux fondations

- Pouvoir rendre la poudrière dans son état originel

- Le bâtiment doit rester accessible aux visites du public,

- Le site doit rester visible aux yeux des visiteurs de la citadelle, avec l’installation d’un sas blindé dissimulant, derrière ses murs, les systèmes informatiques, électriques et de refroidissement

Des caves troglodytes à Saumur

Un consortium d’entreprises se sont réunies dans l’initiative Deepdata (Sigma Informatique, Caisse des dépôts, Enia Architectes, Critical Building, Elioth et Celeste) pour installer leurs serveurs dans des carrières souterraines à l’abandon aux alentours de Saumur.

Enfoui à 30 m de profondeur sous une vigne, le petit data center de 15 m² créé en 2016 est capable de gérer des données d’une entreprise de 1 000 personnes.

- Fraîcheur naturelle et constante de ce milieu souterrain pour refroidir des serveurs informatiques, sans recourir à des systèmes de climatisation

- Sécurité : les caves ne sont pas visibles. Elles sont épargnées en cas de bombardements

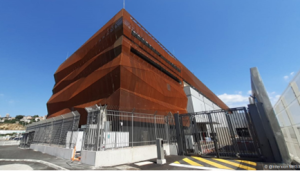

Un bunker à Marseille

La société Interxion a réhabilité une ancienne base allemande de sous-marins. Datant de la seconde guerre mondiale, celle-ci accueille son troisième site d’hébergement informatique dans la cité phocéenne.

Ce bunker immense de 8 000m², est un lieu sécurisé et assez grand pour installer toutes ses machines :

- Plus de 200 mètres de long et 40 mètres de large

- Un toit en béton d’une épaisseur de 5,5 mètres pour protéger l’intérieur en cas de bombardement aérien

- Un mur d’enceinte de 2,6 m d’épaisseur qui servait de rempart.

De plus, cette localisation géographique offre une porte d’accès optimale entre l’Europe, le Moyen-Orient, l’Afrique et l’Asie. Comment ? Grâce à l’arrivée par la Méditerranée de nouveaux télécoms câbles sous-marins reliés à l’internet mondial.

A noter qu’Interxion a ajouté un système de refroidissement mêlant encore une fois innovation et patrimoine. Il s’agit du River Cooling . La société récupère l’eau fraîche d’une galerie minière creusée entre 1890 et 1905 pour refroidir de façon 100% naturelle, par échange thermique, les data centers des environs.

A Barcelone, le plus beau data center du monde

La chapelle du quartier Torre Girona date du XIXè siècle et était à l’abandon sur le campus de l’université polytechnique de Catalogne. Elle abrite des serveurs depuis 2005. Il s’agit du plus grand supercalculateur d’Espagne : le MareNostrum. En 2017, la société DataCenter Dynamics lui a décerné le titre de plus beau data center du monde. Les serveurs sont abrités dans une boite en verre. Cela permet de limiter le volume d’air à ventiler tout en les protégeant de la poussière. De plus, ils bénéficient de la fraîcheur des lieux.

Un abri anti-atomique à Paris

C’est sur un ancien abri anti-atomique construit en 1964 puis laissé à l’abandon, qu’Online a souhaité s’installer. La filiale d’Iliad a acquis en 2012 le bâtiment principal et l’abri souterrain pour une réhabilitation totale. Il est situé à 26 mètres de profondeur sous le bâtiment du laboratoire central des ponts et chaussées dans le 15e arrondissement de Paris. Il offre 7000 mètres carrés d’espace informatique sécurisé répartis entre trois salles.

Une piscine publique à Paris

La start-up française Stimergy a installé des ordinateurs au sous-sol d’une piscine publique classée, en 2017 à la Butte-aux-Cailles, dans le 13ème arrondissement de Paris.

L’objectif : participer à faire des économies de chauffage à cette piscine. Stimergy a mis au point un système de récupération de la chaleur dégagée par les serveurs informatiques. Les batteries d’ordinateurs sont ainsi disposées dans la chaufferie de bâtiments (résidentiels collectifs, piscines…). Les serveurs informatiques sont immergés dans un bain liquide. Des échangeurs thermiques récupèrent la chaleur pour réchauffer l’eau des bassins extérieur et intérieur en maintenant une température de 27 degrés.

Ce système ne contribue pas intégralement au chauffage de la piscine, qui recourt aussi au chauffage urbain de la CPCU.

Nous avons vu ces lieux insolites, nous connaissons les hangars qui cachent nombre de serveurs de manière anonyme. Une grande première mondiale cette année : les fonds marins !

Un data center sous-marin en Ecosse

Il y a quelques semaines, la société française Naval Group a immergé Natik le premier data center sous-marin, à 100 mètres de profondeur au large de l’Ecosse, pour la société Microsoft.

Quelques faits :

- Test en conditions réelles avec de vrais clients pendant au moins 1 an

- Une puissance égale à celle de plusieurs milliers de PC individuels

- Une capacité de stockage équivalente à 5 millions de films

- Conçu pour rester sous l’eau pendant cinq ans grâce à une alimentation par des énergies marines renouvelables

- Soumis aux mêmes règles de sécurité que les datacenters terrestres. Les données hébergées circuleront et existeront aussi ailleurs, dans le cloud et sur terre.

Pourquoi Naval Group ? Le leader européen du naval de défense a su démontrer ses compétences dans la conception, fabrication et maintenance à distance de sous-marins. Mais aussi sa capacité à déployer cette usine électrique et digitale, sous l’eau, grâce à son expérience acquise dans l’installation d’hydroliennes. 75 ingénieurs et les compétences des sites de Cherbourg, Brest, Lorient, Toulon notamment ont été requis pour cette aventure hors du commun !

Et l’espace ?

Hewlett Packard Enterprise (HPE) a annoncé l’envoi d’une troisième itération de son Spaceborne Computer à la Station spatiale internationale (ISS). Le but est de fournir à la communauté scientifique internationale un accès à une gamme élargie de capacités informatiques de pointe, d’IA et de machine learning basées dans l’espace.

HPE Spaceborne Computer-2 offre la performance d’un data center et l’intelligence artificielle ciblée. Elle répond ainsi aux besoins de traitement des données en orbite et faire progresser l’exploration spatiale :

- Des avancées dans le domaine de l’exploration spatiale :

- suivi de la santé des astronautes lors de longues missions spatiales

- aide aux prévisions météorologiques sur Terre.

- Accélérer la prise en compte des besoins critiques en matière de recherche et d’innovation à bord de l’ISS

- Tester plusieurs réseaux d’inférence d’apprentissage profond pour interpréter automatiquement les images télédétectées de la Terre et des structures après une catastrophe :

- Déterminer l’étendue des inondations

- Suivre les dommages causés aux bâtiments urbains, par exemple par des ouragans ou des tremblements de terre.

Ces techniques pourraient être utilisées à bord de futurs engins spatiaux pour fournir rapidement des produits exploitables aux autorités compétentes afin de contribuer à la reprise après une catastrophe.

Traditionnellement, les données recueillies dans l’espace étaient collectées à bord de l’avant-poste de recherche et envoyées sur Terre pour y être traitées. Disposer d’un superordinateur embarqué permet d’évaluer les données en temps quasi réel. Cela permet de réduire de 30 000 fois la taille des téléchargements en ne transmettant à la Terre que la sortie des données, c’est-à-dire l’aperçu.

Le projet ASCEND

L’Union européenne envisage l’installation de data centers. Le projet serait nommé ASCEND (Advanced Space Cloud for European Net zero emission and Data sovereignty). L’objectif avoué de la délocalisation des datacenters dans l’espace serait de limiter leur impact environnemental.

Les Numériques font part de leur scepticisme dans un article sur leur site :

La gestion de la température

« En installant les data centers en orbite et en les alimentant en électricité produite par des centrales solaires “de plusieurs centaines de mégawatts”, on pourrait a priori fortement réduire l’impact écologique de ces infrastructures. Après tout, les satellites en orbite basse de SpaceX fournissent déjà une connexion Internet haut débit pour les abonnés à Starlink. L’évolution rapide des technologies réseaux permet donc d’envisager concrètement un tel scénario.

Au sein du projet ASCEND, avec l’aide de Thales Alenia Space, on travaille donc sur le processus de lancement par fusées des pièces nécessaires à l’assemblage automatique de ces centres de données par des robots. Deux prérequis sont mis en avant : la faisabilité du projet, de sa mise en œuvre à son exploitation et son entretien, et la preuve de son intérêt écologique, dont le coût environnemental total devra être inférieur à l’exploitation des data centers sur Terre.

Et c’est bien là que nous avons d’énormes doutes, pour ne pas dire que nous considérons ce projet comme une fuite en avant technologique déraisonnable. Selon les initiateurs du projet, installer un data center dans un environnement beaucoup plus froid réduirait drastiquement sa facture énergétique. En effet, le refroidissement représente jusqu’à 50 % de la consommation électrique de ces infrastructures, avec une énergie qui reste très majoritairement produite par des sources fossiles à l’échelle mondiale. Or s’il fait jusqu’à -157 °C à l’extérieur de la Station spatiale internationale à 408 km d’altitude, cette température peut monter à 121 °C sous l’effet des rayons du Soleil. L’amplitude thermique d’environ 280 °C poserait à n’en pas douter un sacré défi puisque le matériel informatique n’est pas conçu pour fonctionner à des températures aussi extrêmes. »

La gestion des ressources

« Cela répond aussi à une problématique d’artificialisation des sols, les data centers prenant beaucoup de place. Mais quid des énormes ressources à engager pour y parvenir. Il faudrait compter sur l’impact écologique lié à la conception, la fabrication et l’entretien de tout le matériel nécessaire, les interventions incessantes de robots pilotés depuis la Terre, sans oublier le coût CO2 des lancements pour mettre en orbite aussi bien les racks de stockage que les panneaux de ces hypothétiques fermes solaires orbitales.

Car oui, les lancements de fusées ont une empreinte carbone démesurée, du moins celles dont les moteurs ne fonctionnent pas avec le duo hydrogène/oxygène. On parle alors de 200 à 300 t d’équivalent CO2 pour la seule consommation de carburant d’un lanceur moyen au décollage. Une fourchette qui, bien sûr, n’englobe pas le coût environnemental de la fabrication de ces équipements, encore plus grand. »

Conclusion

A l’ère du calcul HPC et de l’Intelligence Artificielle, les data centers doivent réduire au maximum leur empreinte environnementale. Moins exotique que les exemples détaillés ci-dessus, une manière de le faire est de réhabiliter d’anciennes friches industrielles, des salles informatiques comme l’a fait Nation Data Center avec le retrofit d’anciennes infrastructures à Val de Reuil. Ou encore un ancien centre de tri postal de la Poste transformé par la filiale d’Iliad Scaleway à Saint-Ouen l’Aumône. Nos jumeaux numériques n’ont pas encore en bibliothèque des colonnes romaines ou des poissons à voir à travers les hublots. Toutefois, ils sont une aide indéniable pour imaginer des data centers efficients dans des environnements réinventés pour accueillir des serveurs.